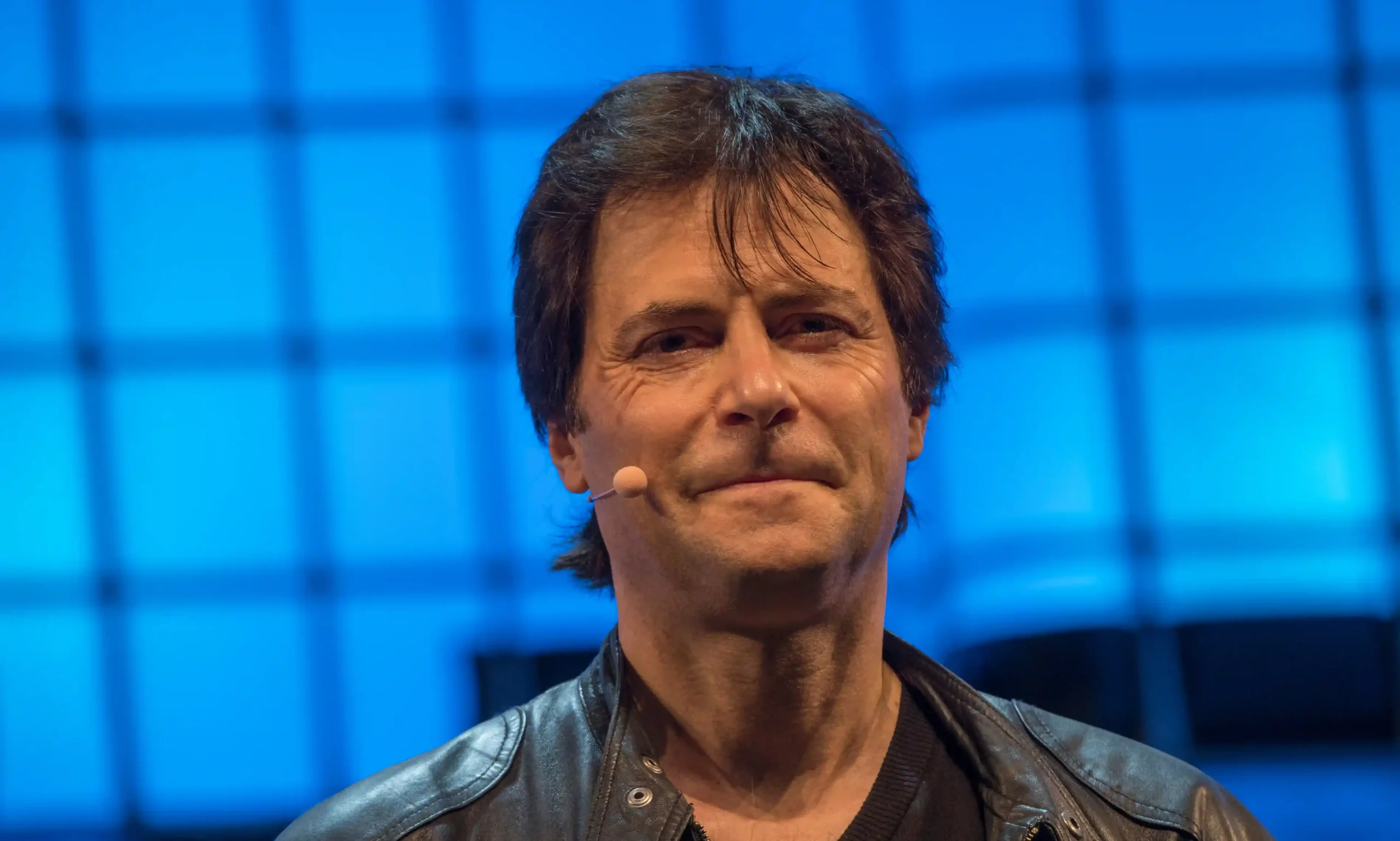

马克斯·泰格马克(Max Tegmark)认为,这种轻描淡写的说法并非偶然,它有可能会延误必要的严格监管,直到为时已晚。

一位著名科学家和 AI 活动家警告说,大科技公司已经成功地转移了全世界对人工智能仍然对人类构成生存威胁的注意力。

在韩国首尔的 AI 安全峰会上接受《卫报》采访时,马克斯·泰格马克表示,将关注点从生命灭绝转移到更为广泛的人工智能安全概念上,可能会延迟对那些最强大程序的创造者实施的严格监管,这难以接受。

“1942年,恩里科·费米(Enrico Fermi)在芝加哥的一个足球场下建造了有史以来第一个能自持链式核裂变的反应堆”, 马克斯·泰格马克也是一位物理学教授,他说,“当时的顶尖物理学家发现这一点时真的吓坏了,因为他们意识到,制造核弹的最大障碍已被克服。只需几年时间就可以制造出核弹——事实上,到1945年进行的‘三位一体实验’(Trinity Test) ,只用了三年时间。”

“能够通过图灵测试(在对话中人们无法分辨出他们是在和人类还是机器对话)的AI模型,也警示了那种可能会失控的人工智能的到来。这就是为什么像杰弗里·辛顿(Geoffrey Hinton)和尤舒亚·本吉奥(Yoshua Bengio)这样的计算机科学家——甚至很多科技公司的CEO,至少在私下里——对此都非常惊慌。”

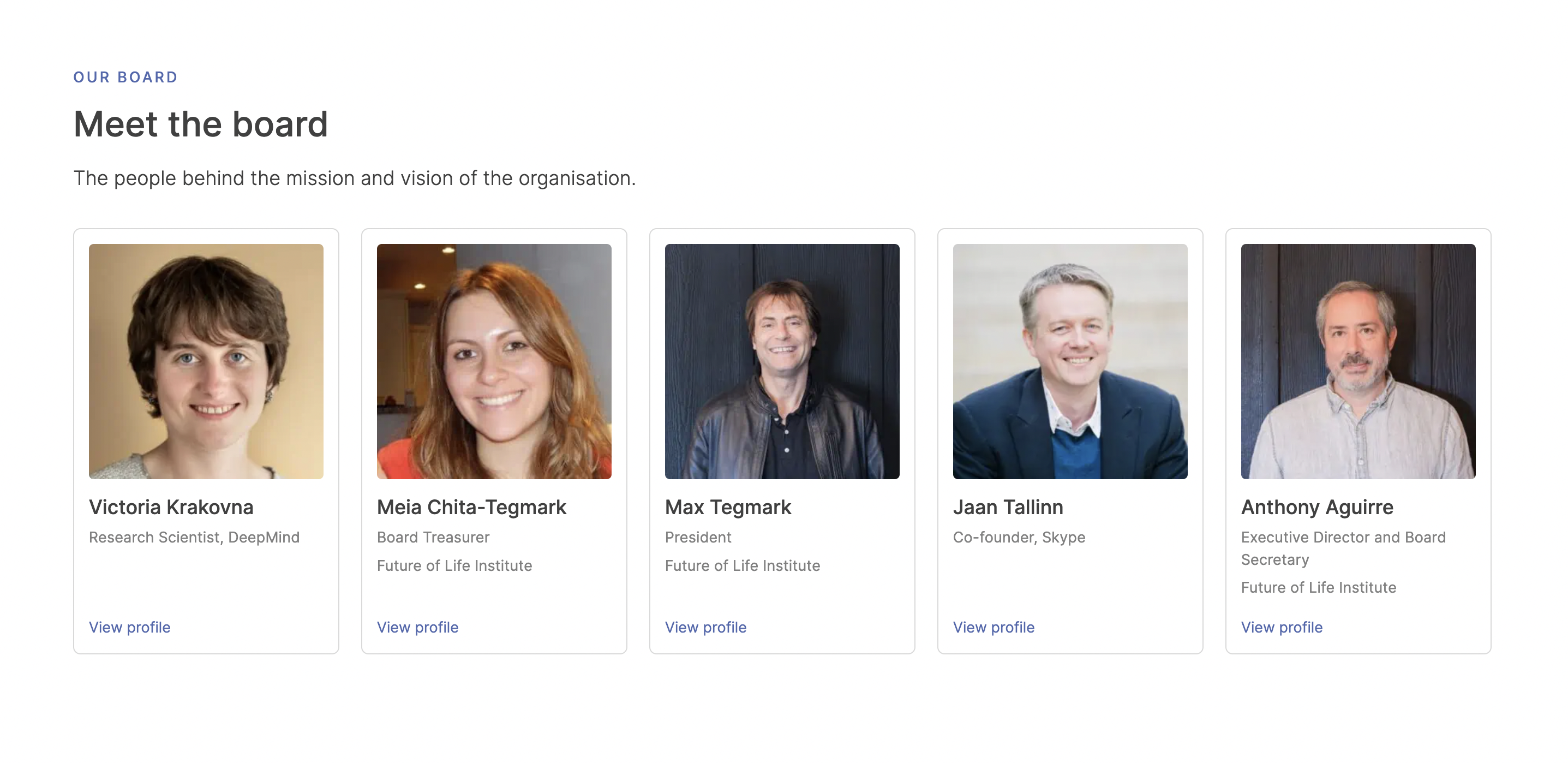

出于这些担忧,泰格马克的非营利性组织 “未来生命研究所”(Future of Life Institute)去年曾呼吁“暂停”开发比GPT-4更强大的 AI 系统至少 6 个月。他说,去年三月 OpenAI 推出的 GPT-4 模型就是煤矿中的金丝雀,预示着风险近在咫尺。

尽管得到了包括辛顿和本吉奥( 三位“AI 教父”中的两位,他们开创的机器学习方法已成当今人工智能领域之基础)在内的1000多名该领域专家的签名,但“暂停”仍未获得同意。

这次在首尔举行的人工智能安全峰会(继去年11月在英国布莱切利公园之后举行的第二次 AI 安全峰会),引领了 AI 监管这一领域的推进。“我们希望这封公开信能让对话合法化,我们很满意这个结果。一旦人们看到像本吉奥这样的人在担心,他们就会想,’我担心这个也是可以的’。就连加油站里的那个伙计在那之后也对我说,他担心 AI 取代我们。”

“但现在,我们需要从纸上谈兵转变为实际的行动。”

然而,自从最初宣布要举办布莱切利公园峰会以来,国际监管 AI 安全的焦点已经从“生存风险”转移。

在首尔,三个“高级别”小组中只有一组直接讨论了安全问题,关注“从隐私泄露到扰乱就业市场再到潜在的灾难性后果”的“全方位”风险。泰格马克认为,对最严峻的风险轻描淡写是不应当的——这也绝非偶然。

“这正是我所预测的行业游说会导致的情况”,他说,“1955 年,第一批指出吸烟导致肺癌的期刊文章发表后,人们以为很快就会有一系列监管措施。实际上没有,一直等到了 1980 年,因为行业有巨大推动力来分散人们的注意力。我觉得现在也是这种情况。”

“当然,AI 也造成了当下的危害:存在这样一种偏见,认为它只对边缘群体构成威胁……但正如英国科学部长米歇尔·多纳兰(Michelle Donelan)所说的那样,我们并非不能同时处理两者。这有点像说,’因为今年会有飓风,我们就不要关注气候变化,只关注飓风就好了’。”

泰格马克的批评者们也用类似的论点驳斥了这种指责:业界希望每个人都谈论假想中的未来风险,以转移人们对当下具体威胁的注意力。“即使你就事论事,这也是让人‘大脑过载’的:对像(OpenAI 创始人)萨姆·奥特曼(Sam Altman)这样的人来说,为了逃避监管,告诉大家这可能对每个人都是灭顶之灾,然后试图说服像我们这样的人敲响警钟,这简直是在下一盘四维国际象棋。”

相反,他认为,一些科技公司的领导者之所以默不作声,是因为“我认为他们都觉得自己处于一个无法摆脱的困境,即使他们想要停止,也做不到。如果一个烟草公司的CEO某天早上醒来,感到自己正在做的事情是不对的,会发生什么?他们会把CEO换掉。因此,要把安全放在第一位就只有政府为所有人制定安全标准。”

译:Youkee